Wertorientierte Zinsbuchsteuerung existiert bereits seit den 90er Jahren, doch die aktuelle Niedrig- beziehungsweise Negativzinsphase führt dazu, dass die bestehenden Mechanismen der barwertigen Zinsbuchsteuerung, insbesondere die Wahl langer Benchmarks wie dem gleitenden 15er, in der Diskussion stehen.

Der vorliegende Artikel analysiert den Status quo in Bezug auf langlaufende Benchmarks im Schrifttum. Zudem werden die Benchmarks einer aktuellen empirischen Analyse unterzogen. Ziel ist die Beantwortung folgender Forschungsfragen:

1. Sind die etablierten Benchmarks auch in Niedrig- oder Negativzinsphasen weiterhin eine gute Möglichkeit zur Erzielung von Fristentransformationsbeiträgen?

2. Sind Benchmarks mit längerer Laufzeit als 10 Jahre aus Risk/Return-Sicht eine effiziente Alternative?

3. Ist eine Hebelung zu empfehlen?

Hierzu wird wie folgt vorgegangen: Zunächst wird der Status quo in der Literatur zum Themenbereich der Benchmarks im Allgemeinen und zu langlaufenden Benchmarks im Speziellen analysiert. Es folgen die empirischen Analysen zur Effizienz möglicher Benchmarks. Weiterhin werden Impulse für die Zinsbuchsteuerung gegeben. Am Ende werden die Erkenntnisse zusammengefasst und die Forschungsfragen beantwortet.

Status quo im Schrifttum

Eine Benchmark ist im Rahmen einer passiven Steuerung eine Position, die nicht leicht zu schlagen ist, am Markt erworben werden und somit als Anlagevehikel dienen kann, wenn keine eigene Marktmeinung vorliegt beziehungsweise der Investor sich sicher ist, den Markt nicht schlagen zu können. Im Rahmen der barwertigen Zinsbuchsteuerung geht das Benchmarking auf Ausarbeitungen des Deutschen Sparkassen- und Giroverbandes (DSGV) Ende der 90er zurück. Sievi hat im Jahr 2000 die Effizienz des gleitenden 10ers hergeleitet und diese Benchmark für die wertorientierte Zinsbuchsteuerung etabliert. Diese sind seitdem im Einsatz und wurden 2011 durch Analysen um den RexP (Deutscher Renten-Performanceindex) ergänzt.

Trotz der umfangreichen und konträren Diskussion in der Praxis findet sich in der Fachliteratur nur eine überschaubare Anzahl von Ausarbeitungen zur Effizienz langlaufender Benchmarks. Ausführungen des Autors gehen auf das Jahr 2008 zurück. Betrachteter Zeitraum ist von Juni 1986 bis Juni 2007. Analysiert werden der gleitende 5er, der gleitende 10er und der gleitende 15er. Der gleitende 15er ist performanter als der gleitende 10er. Letzterer ist jedoch effizienter. Gleichwohl bietet sich der gleitende 15er aufgrund der besseren Performance trotzdem als Beimischung an, da die Abstände in der Effizienzanalyse nicht sehr groß sind.

Die Ausführungen sind mit Stand Juni 2011 und Juni 2017 aktualisiert und um weitere statistische Analysen ergänzt worden. Die Ergebnisse der ersten Analyse sind bekräftigt worden. Der gleitende 10er stellt sich zwar nach wie vor als die effizienteste Benchmark heraus, allerdings sind die Unterschiede zum gleitenden 15er geringer geworden.9) Ergänzend ist festzuhalten, dass ein statisches Hebeln - am Anfang des Betrachtungszeitraums wird ein fester Betrag in Euro gehebelt - nicht effizient ist.

Auch Sievi hat sich des Themas 2016 angenommen. Er kommt zu ähnlichen Ergebnissen, geht methodisch aber anders vor, indem er mit den Begriffen "Überrisiko" und "Überperformance" bei endfälligen Anlagen von 1 bis 15 Jahren argumentiert, um so das Risiko-Ertragsprofil des gleitenden 15ers zu treffen. Nach seinen Analysen ist der gleitende 15er ineffizient im Vergleich zum gleitenden 10er. Einer Hebelung des gleitenden 10ers ist hier der Vorrang zu geben.

Schober kommt 2019 auf Basis von Daten von Juli 1990 bis Dezember 2018 auf Basis einer historischen Ex-ante-VaR-Simulation zum Ergebnis, dass beide Benchmarks gleich effizient sind. Eine ergänzende Monte-Carlo-Simulation zeigt eine marginal bessere Effizienz des gleitenden 15ers. Selbstkritisch führt Schober jedoch an, dass "[e]ine geringfügige Variation in den Annahmen der Monte-Carlo-Simulation dazu führen [könnte], dass die Benchmark gleitend zehn Jahre effizienter erscheint. Die Simulation kann folglich derart interpretiert werden, dass beide als gleichwertig einzustufen sind und keine Dominanz einer Benchmark erkennbar ist."

Die Abweichungen der Ergebnisse der Analysen sind auf die Wahl der Zinskurven und der Zeiträume zurückzuführen. Während die Analysen des Autors im gesamten Zeitraum auf Kuponrenditen deutscher Bundesanleihen basieren, setzt Schober von Juli 1990 bis Dezember 2001 auf diese Kurven, verwendet aber Swap-Daten von Januar 2002 bis Dezember 2018. In Bezug auf den Geldmarkt setzt Schober nur auf den 3M (Monats-)Satz, während die Analysen des Autors auf den 1M-, 3M- und 6M-Satz abzielen und die (statische) Hebelung mit dem 1M-Satz durchführen. Zudem differieren die Berechnungsmethoden. Die Analysen des Autors basieren auf einer Ex-post-Betrachtung (Längsschnittanalyse) der Veränderungen der Benchmarks, während Schober auf Basis der Zinskurvenveränderungen eine Ex-ante-Analyse (Querschnittsanalyse) durchführt. Diese Vorgehensweise ist gröber und hat den Nachteil, dass sie auf die Zinskurve zum Stichtag 31. Dezember 2018 aufsetzt, was zu Basiseffekten in Bezug auf den RORAC führt.

In Summe lässt sich festhalten, dass die Ergebnisse in Bezug auf gleitend 10 und 15 partiell differieren. Von einer Gleichwertigkeit (Schober) über eine leicht schlechtere Effizienz (Ausarbeitungen des Autors) und einer Ablehnung als Benchmark (Sievi) sind alle Sichtweisen vertreten. Da alle Analysen jedoch keine hohe Ineffizienz ergeben, ist auf Basis des aktuellen Schrifttums eine Verwendung langlaufender Benchmarks in der Zinsbuchsteuerung nicht per se zu negieren. Hinzu kommt, dass diese auch in der periodischen Sicht einen hohen Ergebnisbeitrag erzielen. Festzuhalten bleibt, dass der Stand der Forschung überschaubar ist und weitere Analysen erforderlich sind, um die Aussagen zu validieren.

Empirische Herleitung effizienter Benchmarks

Die Effizienz der angesprochenen Benchmarks wird im Folgenden erneut getestet. Neben einer langen Niedrig- und Negativzinsphase sind auch die Effekte der Corona-Krise enthalten, was die Analysen aus akademischer Sicht relevant erscheinen lässt.

Hinzu kommt, dass erstmals der gleitende 20er analysiert wird. Wenn der gleitende 15er auf Basis der im Schrifttum durchgeführten Analysen nicht abzulehnen ist, könnte dies auf noch längere Laufzeiten auch zutreffen. Hierzu werden auf Basis öffentlich zugänglicher Quellen monatliche Werte der Geldmarkt- und Kapitalmarktrenditen herangezogen. Der Untersuchungszeitraum umfasst Juni 1986 bis Dezember 2020. Diese Renditen werden für alle Laufzeiten auf Monatsbasis und für alle 415 Stichtage in Zerobond-Abzinsfaktoren überführt. Ab Juni 1986 wird fiktiv in die jeweilige Struktur investiert. Hierzu wird ein Betrag von 10 000 Euro in monatliche Tranchen aufgeteilt und zu den Kassasätzen (nicht gleitenden Durchschnitten) investiert. Beim gleitenden 10er sind dies folglich 120 Tranchen zu 83,33 Euro, welche in Zerobonds mit Laufzeiten von 1 bis 120 Monate investiert werden. Jeden Monat wird eine Tranche fällig, die dann in einen Zerobond auf Basis des dann gültigen 10J-Satzes investiert wird. Die gleitende Struktur ist beim gleitenden 10er per Juni 1996 erreicht. Beim gleitenden 15er sind es 180 Tranchen zu 55,56 Euro, beim gleitenden 20er 240 Tranchen zu 41,67 Euro. Hier ist die Sollstruktur erst in Juni 2001 beziehungsweise Juni 2006 erreicht. Durch die Tatsache, dass immer in Zerobonds investiert wird, wächst der Wert der Tranche sukzessive mit Restlaufzeitverkürzung an. Eine Modellierung der Zinszahlungen wird so elegant umgangen.

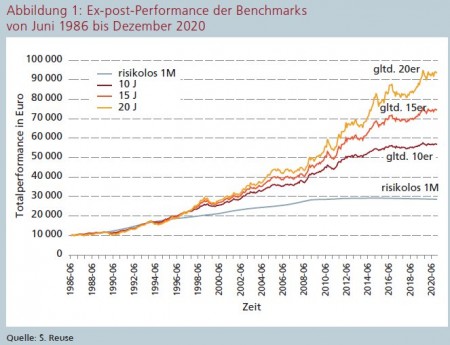

Auf Basis dessen lassen sich Ex-post-Performances einer realen Benchmark modellieren. Abbildung 1 verdeutlicht diese Entwicklungen.

Die Ergebnisse unterstützen vorherige Analysen des Autors. Je länger die Benchmark ausgestaltet ist, desto performanter ist sie. Gerade ab Anfang 2018, wo sich die Zinsen negativ entwickelt haben, sind vor allem beim gleitenden 20er deutliche Steigerungen festzustellen. Dies gilt in abgeschwächter Form auch für den gleitenden 15er und 10er. Grund ist die hohe Fungibilität der Bundeswertpapiere, die aus Sicht des Autors aufgrund des sich immer weiter verstärkenden Anleihe-Ankaufprogramms der EZB eine überdurchschnittliche Performance aufweisen. Eine Analyse mit Swap-Sätzen würde wahrscheinlich zu einem nicht ganz so spürbaren Effekt führen. Zu erkennen ist eine deutlich höhere Schwankungsbreite der längeren Benchmarks. Die risikolose Anlage verliert seit einigen Jahren an Wert. Grund ist der negative Geldmarktzins.

RORAC erst ab 5 Jahren auf adäquatem Niveau

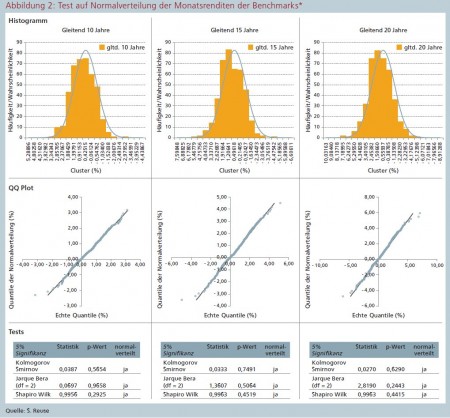

Für eine vollständige Interpretation ist eine Risiko-/Renditeanalyse erforderlich. Hierzu wird ein Value-at-Risk (VaR) auf Basis eines 99-prozentigen Konfidenzniveaus modelliert. Basis sind Monats-Per for mances und überlappende Jahres-Performances der berechneten Ex-post-Benchmarks. Neben der historischen Simulation (Abgriff des Quantils adjustiert um Erwartungswert) wird aufgrund der vergleichsweise geringen Stichprobe (Juni 1986 bis Dezember 2020 = 415 Stichprobenwerte) auch der Varianz/Kovarianz-Ansatz herangezogen, wenn die Renditen einer Normalverteilung unterliegen. Die Monatsrenditen der drei Benchmarks werden entsprechend auf Normalverteilung getestet (5 Prozent Signifikanz) und zusätzlich mit Histogrammen und QQ-Plots in Abbildung 2 visualisiert.

Es ist zu erkennen, dass die Renditen bis auf die Ränder der Verteilung - in der Regel sogar erst über dem 99-Prozent-Quantil - einer Normalverteilung folgen. Eine Verwendung der VaR-Werte der Varianz-Kovarianz-Version ist ebenso möglich wie eine Skalierung der Werte auf die gewünschte Laufzeit mit der Wurzel-t-Funktion.

Zur besseren Vergleichbarkeit werden alle Werte auf ein Jahr skaliert. Folglich existieren zwei Arten der Risikomessung und zwei Zeiträume, was vier verschiedene Risikomessverfahren zur Folge hat. Hinzu kommt die Ermittlung des RORAC, der die Überrendite über die sichere Rendite (hier der 1M-Satz) zum VaR als Abweichung zum Erwartungswert ins Verhältnis setzt. Zusätzlich wird diese Analyse für einen kürzeren Zeitraum von Januar 1999 bis Dezember 2020 durchgeführt. Grund ist die mathematische und ökonomische Argumentation von Stoklossa, dass nur der Zeitraum der EWWU ab Januar 1999 als repräsentativ für die weitere Entwicklung gelten kann, längere Zeiträume würden zu einer Fehlbewertung führen. Das Ergebnis visualisiert Abbildung 3.

Auch diese Ergebnisse unterstützen bisherige Analysen des Autors. Auf Basis dieser Ergebnisse lässt sich Folgendes festhalten: Der gleitende 10er ist in der Regel der effizientere Wert im Vergleich zum gleitenden 15er, auch wenn dieser oft nur marginal schlechter ist. Der gleitende 20er ist noch einmal ineffizienter als der gleitende 15er, sodass dessen Abstand zum gleitenden 10er in etwa doppelt so hoch ist wie der des gleitenden 15ers. Folglich ist der gleitende 20er als Benchmark nur eingeschränkt geeignet. Gleichwohl hat er eine deutlich höhere Performance und der RORAC ist trotz allem nur unwesentlich schlechter als der des gleitenden 10ers.

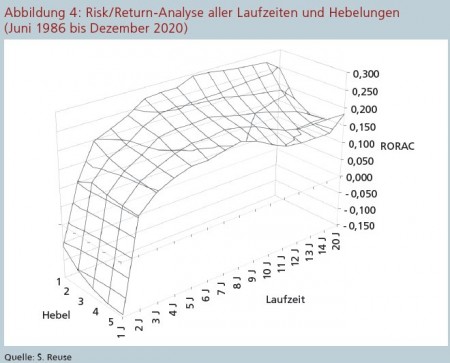

Werden in einem letzten Schritt alle Benchmarks und auch Hebelungen statischer Art in die Analysen mit einbezogen, so ergibt sich auf Basis der historischen Simulation und monatlicher Basis Abbildung 4, welche die RORACs entsprechend darstellt.

Auf Basis der Analysen lässt sich ableiten, dass die RORACs im 1J-Bereich negativ und erst bei circa fünf bis sechs Jahren ein adäquat hohes Niveau annehmen. Benchmarks bis zu diesen Laufzeiten lohnen sich folglich kaum. Laufzeiten um 10 Jahre stellen sich am effizientesten dar. Dies unterstützt die Eignung des gleitenden 10ers als Benchmark erneut. Längere Laufzeiten werden ineffizienter, was ihre Eignung als Benchmark infrage stellt. Gerade der gleitende 20er fällt noch einmal ab.

Impulse für Zinsbuchsteuerung

Je stärker der (ursprüngliche statische) Hebel wird, desto ineffizienter wird die Struktur. Dies macht sich vor allem bei langlaufenden Benchmarks bemerkbar. Eine Ausnahme bildet die statische Hebelung 5 mit sehr langen Benchmarks. Die Begründung liegt hier in den Phasen am Anfang der Simulation um 1990, wo hochgehebelte Strukturen auch Werte deutlich unter dem Anfangsinvestment von 10 000 Euro annehmen konnten. Prozentuale Steigerungen verzerren dann die Werte. Bei der kurzen Historie ab Januar 1999 ist diese Anomalie nicht zu beobachten, die anderen Ergebnisse bestätigen sich jedoch.

Bei einer dynamischen Hebelung (jeden Monat wird der Hebel adjustiert) variieren die RORACs in Abhängigkeit vom Hebel nur leicht. In der Regel sind ungehebelte Strukturen marginal effizienter. Dies spricht, wenn gehebelt werden soll, für eine dynamische Hebelung, zeigt aber auch, dass die Wahl der Hebelungsstrategie für die Effizienz des Zinsbuches wichtig ist.

Die Ergebnisse bestätigen bisherige Erkenntnisse und zeigen auf, dass Benchmarks länger als 10 Jahre mit Vorsicht zu genießen sind. Dies trifft umso mehr auf gehebelte Strukturen zu. Die Effizienz des gleitenden 10ers ist jedoch erneut bestätigt worden. Passiv steuernde Institute sind gut beraten, diese auch weiterhin zu verwenden. Je länger die Benchmark wird, umso mehr hängt ihr Erfolg auch von der Hebelung ab.

Auf Basis der Erkenntnisse der obigen Analysen lassen sich mehrere Impulse für die Zinsbuchsteuerung ableiten. So ist aus Sicht des Autors eine geringe Beimischung von Teilen des gleitenden 15ers nicht schädlich, da die Transaktionskosten zur Herstellung der Cashflow-Struktur des gleitenden 10er dessen marginalen Effizienzgewinn überkompensieren könnten. Bis zu 20 Prozent Beimischung sind aus Sicht des Autors adäquat, vor allem, wenn es originäres Kundengeschäft im 15-Jahres-Band gibt. Ob dies auf 20 Jahre ausgeweitet werden sollte, ist aus Sicht des Autors kritisch zu hinterfragen. Viel originäres Kundengeschäft dürfte es in diesen Laufzeitbändern bei Banken nicht geben. Zudem führen schon geringe Volumina in langen Laufzeiten schnell zu einem deutlich höheren barwertigen Zinsänderungsrisiko, was sich nachteilig im SREP -Eigenkapitalzuschlag auswirken kann. Hier sollten Institute sehr defensiv agieren.

Längere Laufzeiten

Die Analysen zeigen, dass die statische Hebelung nicht effizient ist, die (bekannte) dynamische Hebelung, in der bei steigendem Barwert auch der Hebel steigt, hingegen sinnvoller sein kann. Es bietet sich also an, Strategien für die Höhe des Hebels zu entwickeln, die in Abhängigkeit der Attraktivität des Zinsmarktes modelliert werden. Steile Kurven könnten einen höheren Hebel bedeuten und vice versa. Dies gilt es im Rahmen weiterer Untersuchung zu verifizieren.

Neben anderen möglichen Benchmarks - zum Beispiel gleitend 6 bis 15 Jahre oder 11 bis 15 Jahre - bietet sich auch eine aktivere Steuerung des Zinsrisikos in Zeiten der Negativzinsphase an. Zum einen ist die Zinskurve seit längerer Zeit flach, zum anderen beeinträchtigen negative Marktzinssätze manche Strategien, da in einem normalen Bankbuch negative Zinsen aus rechtlicher Sicht nicht überall eins zu eins an den Kunden weitergegeben werden können. So sind große Teile der Passivseite einer Bank "gefloort". Hier ist auch die Integration der Option in das Zinsbuch sowie die empirische Analyse aktiver Komponenten aus Sicht des Autors zumindest zu prüfen. Ein strenger regelbasierter semiaktiver Prozess kommt einer passiven Benchmark-Steuerung zudem recht nah.

In Bezug auf die Forschungsfragen lässt sich festhalten:

1. Bekannte Benchmarks sind nach wie vor in der Lage, trotz des aktuellen Zinsniveaus und der Flachheit der Zinskurve einen adäquaten Beitrag zu erzielen. Abbildung 1 hat den deutlichen Performance-Schub seit Anfang 2018 aufgezeigt. Das aktuelle Niedrigzinsniveau führt somit zu steigenden Barwerten. Ergänzend sei kritisch angeführt, dass die Frage, wann sich diese Effekte in der GuV niederschlagen, nur mit der Integration von Neugeschäften in das Kalkül beantworten lässt .

2. Benchmarks mit längerer Laufzeit als 10 Jahre sind aus Risk/Return-Sicht nur bedingt sinnvoll. In Summe lässt sich festhalten, dass der gleitende 15er marginal ineffizienter ist als der gleitende 10er. Der gleitende 20er ist spürbar ineffizienter, was sich vor allem bei höheren Hebelungen bis 4 deutlich bemerkbar macht. Als Beimischung sind längere Benchmarks durchaus geeignet, allerdings sollte dies umso defensiver geschehen, je länger und je höher die Position gehebelt ist.

3. Eine Hebelung ist wenn, dann nur dynamisch zu empfehlen. Gleichwohl ist der Vorzug ungehebelten Strukturen zu geben. Diese sind in der Regel effizienter. Verstärkend kommt die zur Zeit sehr flache Zinskurve hinzu, die die Sinnhaftigkeit des Hebelns einschränkt.

Die vorliegenden Analysen wurden aus barwertiger Sicht erstellt. Bleiben die Zinsen noch länger auf dem niedrigen (und zurzeit auch flachen Niveau), so wird die Bank überleben, die am längsten eine hohe Zinsspanne aufweisen kann. Dies ist nur mit längeren Laufzeiten möglich. Die seit 13 Jahren existierende Idee des Autors, zumindest partiell in diese Laufzeiten zu investieren , hätte Banken heute deutlich höhere Zinsspannen und Barwerte beschert, was wiederum ein Polster für die sicherlich nicht einfach werdende Zukunft hätte sein können.

Fußnoten

1) Dieser Artikel basiert auf den Ausführungen aus Reuse, S. (2019): Definition effizienter Benchmarks für die passive Steuerung, in: Reuse, S. (Hrsg.): Zinsrisikomanagement, 3. Auflage, Heidelberg 2019, S. 377-394.

2) Vgl. umfassend Reuse, S. (2011): Korrelationen in Extremsituationen - Eine empirische Analyse des deutschen Finanzmarktes mit Fokus auf irrationales Marktverhalten, Gabler Verlag 2011, 307 Seiten, zugleich Dissertation an der Masaryk Universität Brünn, S. 15 und die dort angegebenen Quellen.

3) Vgl. hierzu umfassend aktuell Reuse, S. (2019, Hrsg.): Zinsrisikomanagement, 3. Auflage, Heidelberg 2019. Erste umfassende Ausarbeitungen zur barwertigen Steuerung finden sich in Goebel, R. / Sievi, C. / Schumacher, M. (1999): Wertorientiertes Management und Performancesteuerung, Stuttgart 1999.

4) Vgl. Sievi, C. (2000): Projekt "Typische Zinsszenarien und Dispositionskonzept" - Abschlußbericht - DSGV Berlin 2000, Kapitel 8, S. 1 ff. und Sievi, C. (2001): Studie - Steuerung des Zinsbuches einer Sparkasse - aktives versus passives Management, Abschlußbericht - DSGV Berlin 2001, S. 48 ff. Umfassend analysiert in Wegner, O. / Sievi, C. / Schumacher, M. (2002): Benchmarks im Rahmen der wertorientierten Steuerung des Zinsänderungsrisikos, in: Betriebswirtschaftliche Blätter, 51. Jg., Nr. 07 / 2002, S. 313-320.

5) Vgl. Sievi, C. / Wegner, O. / Freundorfer, E. (2011): Integration von Marktpreisrisiken, Stuttgart 2011, erhältlich auf: https://www.dr-sievi.de/buecher/, Abfrage vom 02.01.2021, S. 152 ff.; 275 ff.

6) Vgl. Reuse, S. (2008): MaRisk-konforme Überwachung, Bewertung und Reporting von Zinsänderungsrisiken, in: FC Heidelberg (Hrsg.): Zinsrisikomanagement, Heidelberg 2008, S. 171-265, S. 200 ff.; Frère, E. / Reuse, S. / Svoboda, M. (2008): Der gleitende 15-Jahresatz im Kontext etablierter Benchmarks - sind diese zu schlagen?, in: Bankpraktiker, 3. Jg., Ausgabe 05 / 2008, S. 232-236.

7) Vgl. Reuse, S. (2012): Definition effizienter Benchmarks für die passive Steuerung, in: Reuse, S. (Hrsg.): Zinsrisikomanagement, 2. Auflage, Heidelberg 2012, S. 159-167.

8) Vgl. Reuse, S. (2019): a.a.O. (Fn. 1), S. 377-394.

9 )Auch auf Basis ausländischer Kapitalmärkte ließen sich in Bezug auf den gleitenden 10er ähnliche Ergebnisse festhalten. Vgl. Reuse, S. / Svoboda, M. (2014): Empirical Analysis of the Efficiency of Maturity Transformation in the Czech Republic, in: Intercontinental Journal of Finance Research Review, 2. Jg., Nr. 5, Mai 2014, S. 1-16 / S. 36-51.

10) Vgl. Sievi, C. (2016): Niedrigzinsphase Modul 2: Steuerung des Zinsänderungsrisikos; Phase 2 Projektdokumentation im Auftrag des Deutschen Sparkassen- und Giroverbandes, 08.08.2016, S. 127-136.

11) Vgl. Schober, M. (2019): Benchmark gleitend zehn und 15 im Vergleich, in: SparkassenZeitung vom 14.03.2019, erhältlich auf: https://www.rolandeller.de/fileadmin/Redaktion/Fachartikel/benchmark-gleitend-zehn-und-15-im-vergleich.pdf, Abfrage vom 03.01.2021.

12) Schober, M. (2019): a.a.O. (Fn. 11).

13) Return on Risk Adjusted Capital = Überrendite einer Anlage zur sicheren Rendite in Bezug auf das Risiko.

14) Vgl. Balke, C. / Bader, T. (2016): Zinsbuchsteuerung im Nullzins-Umfeld, in: Die Bank, Heft 07 / 2016, S. 8-13.

15) Vgl. Deutsche Bundesbank (2021): Geldmarktzinsen und Kapitalmarktzinsen. Für den Geldmarkt wurden bis 12.1998 Zinsen des Frankfurter Bankplatzes verwendet (Kurven BBK01.SU0104, 0107, 0250). Ab 01.1999 wird auf Euriborwerte zurückgegriffen (Kurven BBK01.SU0310, 0316, 0325). Zur Glättung wird auf Monatsdurchschnittswerte zurückgegriffen. Im Kapitalmarkt wird auf die aus der Zinsstruktur abgeleitete Renditen für börsennotierte Bundeswertpapiere mit jährlicher Kuponzahlung abgestellt (Kurven BBSIS.M.I.ZAR.ZI.EUR.S1311.B.A604.R01XX. R.A.A._Z._Z.A - R20XX). Hierbei handelt es sich um Renditestrukturen und somit um Kuponzinssätze.

16) Die Vorgehensweise sowie die mathematische Modellierung finden sich ausführlich in Reuse, S. / Svoboda, M. (2014): a.a.O. (Fn. 9), S. 1 ff.

17) In Anlehnung an Reuse, S. (2019): a.a.O. (Fn. 1), S. 381.

18) Vgl. hierzu auch Reuse, S. (2019): a.a.O. (Fn. 1), S. 384.

19) In Anlehnung an Reuse, S. (2019): a.a.O. (Fn. 1), S. 385. Tests erfolgten mit r. 415 Stichtagswerte führen zu 414 Monatsperformances.

20) Bei kürzeren Laufzeiten bis zu ca. 5 Jahren ist dies nicht zwingend der Fall, vgl. Reuse, S. (2019): a.a.O. (Fn. 1), S. 386. Aktuelle Analysen bestätigen diese Ergebnisse.

21) Skalierung der Standardabweichungen der Indizes mit dem z-Wert. Es handelt sich streng genommen nicht um eine Anwendung des Varianz / Kovarianz-Ansatzes, da Korrelationen bereits inhärent in die Entwicklung des jeweiligen Indexes Eingang gefunden haben.

22) Vgl. Reuse, S. (2011): a.a.O. (Fn. 2), S. 148, 179 und die dort angegebenen Quellen.

23) Vgl. Stoklossa, H. (2011): Die Parametrisierung des Value at Risk in der Bankensteuerung, in: Risiko Manager, Nr. 12 / 2011, S. 1 und 8-13.

24) In Anlehnung an Reuse, S. (2019): a.a.O. (Fn. 1), S. 388. Skalierung auf Jahresbasis: Ermittlung Risiko mit Wurzel 12, Ertrag mit Faktor 12.

25) In Anlehnung an Reuse, S. (2019): a.a.O. (Fn. 1), S. 391.

26) Ohne Abbildung.

27) Dass gehebelte RORACs nicht exakt gleich sind, ist zudem auch in der Berechnungsart begründet. Bei einer Ex-post-Berechnung / Längsschnittanalyse weist auch die risikolose Anlage ein Schwankungsrisiko sowie eine Korrelation kleiner 1 zur Benchmark auf. Dies wirkt sich marginal auf den RORAC und auch auf die Kapitalmarktlinie im Risk / Return-Diagramm aus. Vgl. umfassend Sievi, C. / Wegner, O. / Schumacher, M. (2008): Integration von Marktpreisrisiken (Teil 4)- Risikolimitierung und Vermögensoptimierung, in: Betriebswirtschaftliche Blätter, 57. Jg., 07 / 2008, S. 395-404, S. 400.

28) Supervisory Review and Evaluation Process.

29) Vgl. exemplarisch und anschaulich Beck, M. / Müller, J.-D. (2019): Zinsbuchsteuerung im Niedrigzinsumfeld, in: Eller, R. / Heinrich, M. (Hrsg.): Jahrbuch Treasury- und Risiko-Management 2019 / 2020, S. 17-28; Menninghaus, W. / Ellenbeck, R. / Kaufmann, P. / Bette, H.-G. (2013): Ausgestaltung der Treasury-Konzeption - Potenziale nutzen, erhältlich auf: https://bankinghub.de/wp-content/uploads/2013/08/zeb_Themen_Integriertes_Treasury.pdf, Abfrage vom 02.01.2021, S. 12.

30) Vgl. umfassend schon Ophorst, P. (2017): Konzeption zur Bestimmung einer dynamischen Zinsbuch-Benchmark für das Bank-Treasury, Dissertation Heinrich-Heine-Universität Düsseldorf, erhältlich auf: https://docserv.uni-duesseldorf.de/servlets/DerivateServlet/Derivate-47775 / Dissertation%20Pascal%20Ophorst%204%20August%202017.pdf, Abfrage vom 02.01.2021.

31) Vgl. exemplarisch Beck, M. / Müller, J.-D. (2019): a.a.O. (Fn. 29), S. 21.

32) Zur kritischen Diskussion der Überführung wertorientierter Erfolge in die GuV vgl. Reuse, S. (2016): Periodische versus wertorientierte Zinsbuchsteuerung im Kontext des Niedrigzinsumfeldes, in: ZfgK - Zeitschrift für das gesamte Kreditwesen, 69. Jg., 1. Februar 2016, Heft 3, Frankfurt, S. 138-142.

33) Vgl. Reuse, S. (2008): a.a.O. (Fn. 6), S. 200 ff.; Frère, E. / Reuse, S. / Svoboda, M. (2008): a.a.O. (Fn. 6), S. 232 ff.

34) Vgl. hierzu auch Reuse, S. (2019): a.a.O. (Fn. 1), S. 394. Die in diesem Beitrag geäußerten Auffassungen sind die des Autors und müssen nicht notwendigerweise mit denen des Arbeitgebers übereinstimmen.